Видео с ютуба Multihead Attention

Погружение в многоголовое внимание, внутреннее внимание и перекрестное внимание

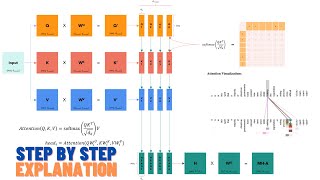

Attention in transformers, step-by-step | Deep Learning Chapter 6

How Attention Mechanism Works in Transformer Architecture

Introduction to Multi head attention

Multi-Head Attention Visually Explained

Visualize the Transformers Multi-Head Attention in Action

Visual Guide to Transformer Neural Networks - (Episode 2) Multi-Head & Self-Attention

Внутреннее внимание против многоголового внутреннего внимания

L19.4.3 Многоголовое внимание

Multi Head Attention in Transformer Neural Networks with Code!

Внимание — это всё, что вам нужно (Transformer) — объяснение модели (включая математику), вывод и...

Multihead Attention's Impossible Efficiency Explained

Что такое многоголовое внимание в нейронных сетях-трансформерах?

Attention mechanism: Overview

Multi-head Attention. Лекция 19.

The Multi-head Attention Mechanism Explained!

Multi-Head Attention (MHA), Multi-Query Attention (MQA), Grouped-Query Attention (GQA) #transformers

![How DeepSeek Rewrote the Transformer [MLA]](https://ricktube.ru/thumbnail/0VLAoVGf_74/mqdefault.jpg)

How DeepSeek Rewrote the Transformer [MLA]

Implementation of Multi-Head-Attention using PyTorch